Merging Webinar Series

Zeitnah finden weitere Webinare von Merging Technologies statt: 10. Juli 2020: Anubis monitoring - how to operate - new EQ 21. Juli 2020: NEW Merging Audio Device: the new Win…

Waves: 15% auf PlugIns

vom 16. bis zum 18. Juni 2020 gibt es bei uns 15% auf alle Waves PlugIns. Der Rabett wird bei Bestellung zusätzlich vom Shop-Preis abgezogen. Bei Fragen kontaktiert uns gern!

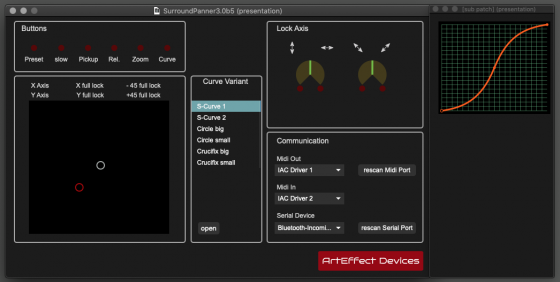

ArtEffect Nuage Panner

JLCooper stellt den Surround-Panner nicht mehr her. Für Nuage-Besitzer und Nuendo-/Cubase-User schließt der Nuage-Panner von ArtEffectDevices nun die Lücke. Er ist als Einbau-Version für Small Workspace sowie Standalone-Version für…

Soyuz 013 Series FET Review

"A flattering sound with a dose of healthy vintage nostalgia" Der Gitarrist und Composer Konstantine Margaritis hat einen Testlauf der SOYUZ Microphones 013 Series FET mit klassischer Gitarre durchgeführt.…

Exzellente Anubis Review von Sound on Sound

Sound on Sound hat kürzlich eine exzellente Review zu Merging + Anubis veröffentlicht. Das Interface kommt nicht nur überdurchschnittlich gut weg, es findet sich auch ein umfassender Überblick über die…

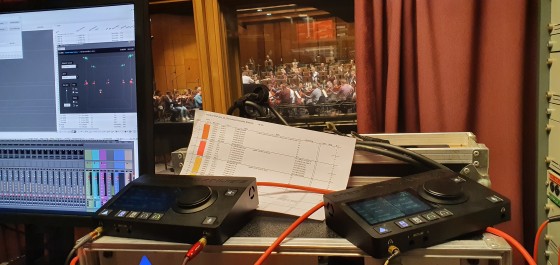

3D-Mikrofonierungen im Test

Zusammen mit Tonmeister Harald Gericke und Hyunkook Lee haben wir das Volkstheater Rostock besucht und einen Testlauf verschiedener 3D-Mikrofonierungen anhand eines Orchesters vorgenommen. Als Komplementär nahmen wir im Tonstudio Tessmar…

Arturia KeyLab 49 MKII Aktion: Gratis V-Collection 6 bei Registrierung

Noch bis zum schenkt Arturia allen KeyLab 49 MKII Käufern eine Vollversion der V-Collection 6! Alle Kunden, die in diesem Zeitraum ein KeyLab 49 MKII bei Arturia registrieren, bekommen automatisch…

Bald neu: Flock Audio PATCH xt und PATCH lt

Ein Jahr nach Erscheinen des PATCH SYSTEM, der digital steuerbaren Analog-Patchbay, kündigt Flock Audio zwei neue Produkte für Sommer bzw Jahresende 2020 an. PATCH LT – Das erschwingliche 16x16 (32…

BAE, Slate MT und Burl Black Friday Sale

Diese Special Offers gibt's zum Jahresende: Burl Audio: 10% auf alles, nur noch bis zum BAE: 10% auf Gear- und Rackmounts, 500-Series, 10-Series, Pedale und Zubehör bis zum Slate Media…